Table of Contents

- Points clés

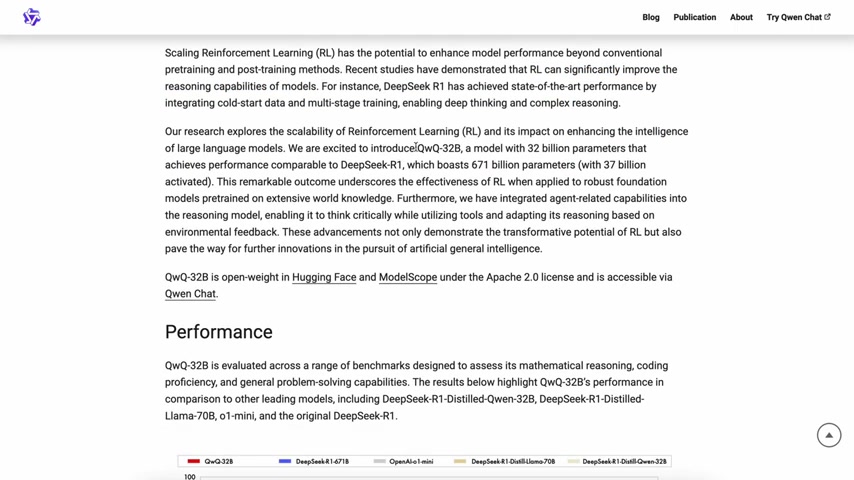

- Présentation de QWQ-32B : un nouveau concurrent dans le domaine des modèles de langage

- Comparaison des benchmarks : évaluation des performances du QWQ-32B

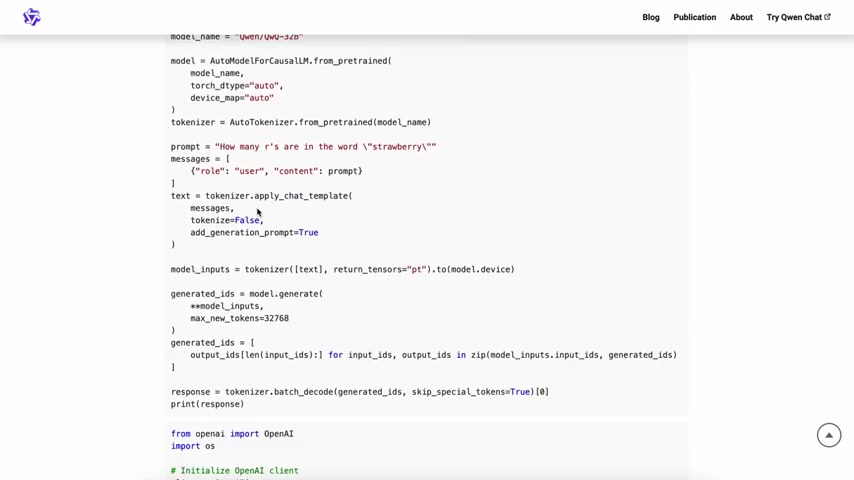

- Comment utiliser le QWQ-32B : options d'exécution locale et en nuage

- Avantages et inconvénients du QWQ-32B

- Principales caractéristiques du QWQ-32B : capacités et avantages

- Cas d'utilisation du QWQ-32B : potentiel dans différents domaines

- FAQ

- Questions connexes

Most people like

< 5K

< 5K

0

0

< 5K

< 5K

0

0

8.7K

8.7K

0

0

137.9K

137.9K

14.05%

14.05%

3

3

713.6K

713.6K

15.23%

15.23%

3

3

- App rating

- 4.9

- AI Tools

- 100k+

- Trusted Users

- 5000+

WHY YOU SHOULD CHOOSE TOOLIFY

WHY YOU SHOULD CHOOSE TOOLIFY

TOOLIFY is the best ai tool source.

- La puissance ultime ou le meilleur rapport qualité-prix ? Découvrez les processeurs Intel Alder Lake !

- Découvrez comment overclocker votre processeur pour des performances hors du commun !

- Assemblez votre PC bon marché avec Core 2 Quad Q6600 et GTX 550 TI !

- Comment exécuter Xbox Game Pass sur votre Android TV avec Cloud Gaming

- Comment vous connecter à Fortnite sans clavier ni manette ?

- Le processeur AMD Ryzen 5 3600 : performances de jeu et multitâche impressionnantes

- 💻 Construisez un PC de jeu et d'édition à moins de 12 000 Rs | PC de jeu budget Core i5 et performances

- Le duel ultime : Ryzen 4000 vs Intel 10e génération sur le XMG Core 15

- Découvrez le puissant processeur INTEL Core i7-14700K

- Nouvelles d'AMD: Processeurs Zen 4, RDNA3 & Bons résultats financiers